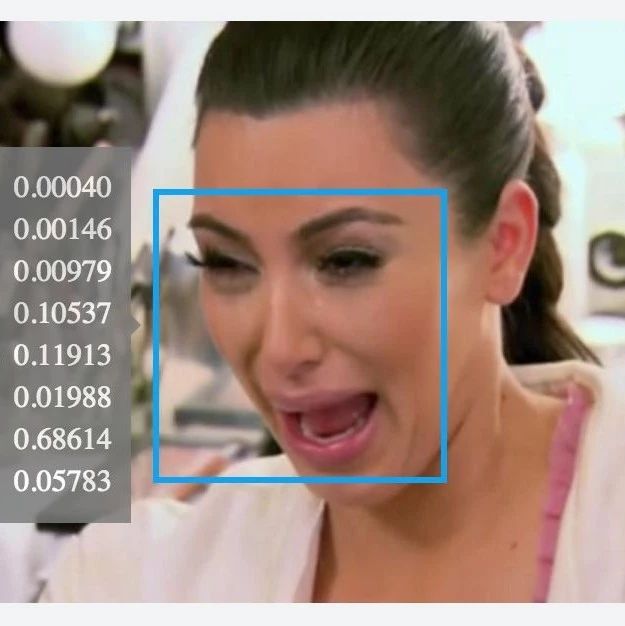

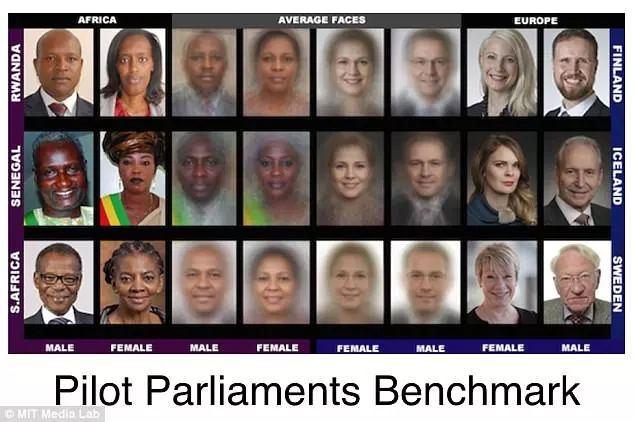

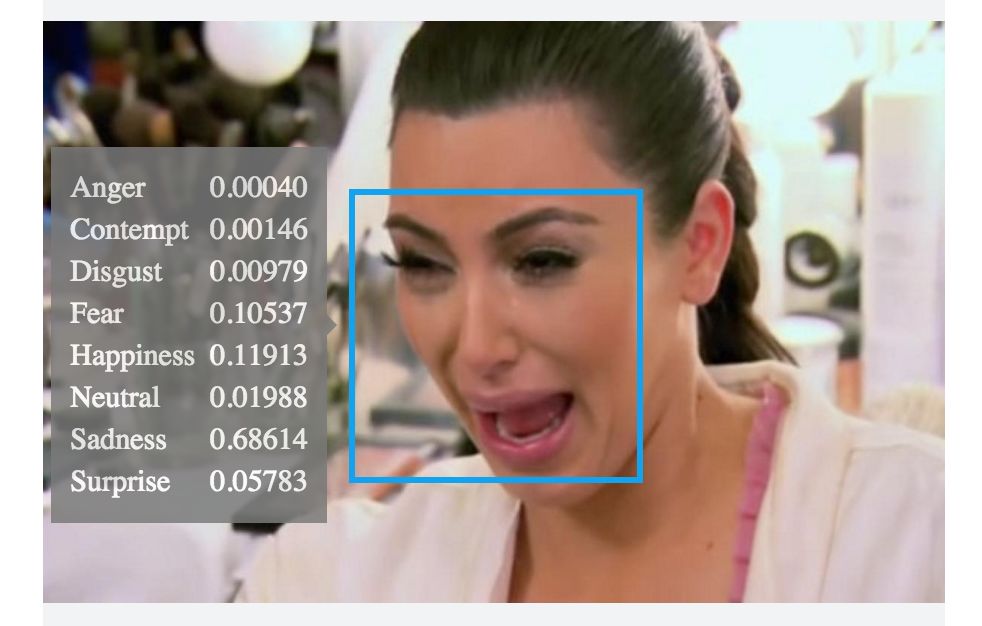

人脸识别出现“技术偏见”,长得太黑无法识别?

2018年06月28日 23:42:54

来源:爱范儿

原标题:人脸识别出现“技术偏见”,长得太黑无法识别? 在演唱会“抓逃犯”上屡建奇功的人脸识别,其实还

原标题:人脸识别出现“技术偏见”,长得太黑无法识别?

- 好文

- 钦佩

- 喜欢

- 泪奔

- 可爱

- 思考

凤凰网科技官方微信

视频

-

李咏珍贵私人照曝光:24岁结婚照甜蜜青涩

播放数:145391

-

金庸去世享年94岁,三版“小龙女”李若彤刘亦菲陈妍希悼念

播放数:3277

-

章泽天棒球写真旧照曝光 穿清华校服肤白貌美嫩出水

播放数:143449

-

老年痴呆男子走失10天 在离家1公里工地与工人同住

播放数:165128

图片新闻