DeepSeek公布推理引擎开源路径,承诺将核心优化注入vLLM生态

独家抢先看

“源神”DeepSeek 又有新的开源动作了。4 月 14 日,DeepSeek 悄悄在其 GitHub 的 open-infra-index 库中公布了其自研推理引擎的开源计划。在公告中,DeepSeek 表示,他们并不会选择直接开其内部完整且高度优化的代码库,而是将采取一种更侧重协作、更具可持续性的策略,将其核心优化成果贡献给现有的开源项目,尤其是作为其技术基础的 vLLM。

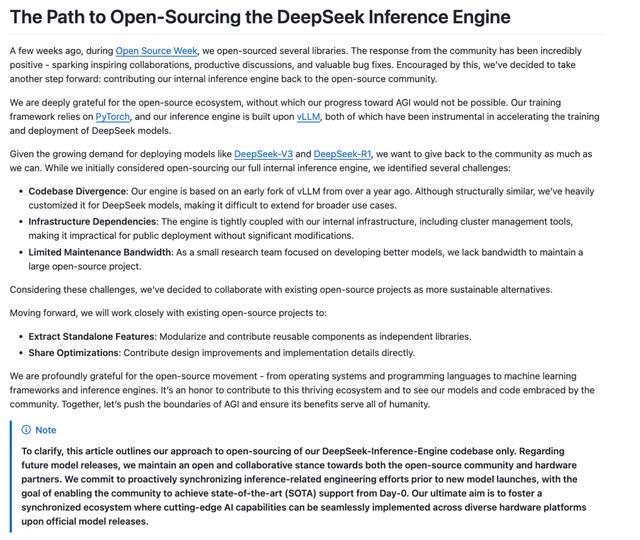

DeepSeek 在其公告中首先对开源生态系统表达了诚挚的感谢,承认其在模型训练(依赖 PyTorch 等框架)和推理引擎构建(早期基于 vLLM)方面都深受开源社区的裨益。随着自研的 DeepSeek-V3、DeepSeek-R1 等模型展现出强大的能力,市场对其高效部署方案的需求与日俱增,促使 DeepSeek 思考如何将自身的进展回馈给社区。

图丨公告原文(来源:GitHub)

然而,在评估了直接开源内部完整推理引擎的可行性后,DeepSeek 认为存在几个关键障碍。首先是显著的代码库分歧。其内部引擎源自一年多前的 vLLM 早期分支,经过长期针对 DeepSeek 模型的深度定制优化,已与 vLLM 主线或其他通用推理框架产生巨大差异。直接开源此版本不仅难以被社区广泛应用和扩展,维护成本也极高。

其次是基础设施强依赖。该引擎与 DeepSeek 内部的集群管理系统、特定的硬件配置和运维流程紧密耦合,外部用户几乎无法在标准环境下直接部署,需要进行大规模重构才能剥离这些依赖,这违背了开源项目通常追求的易用性原则。

最后是有限的维护带宽。DeepSeek 坦言,作为一家以模型研发为核心的团队,他们缺乏足够的资源来长期维护一个需要持续投入、支持广泛用例的大型开源项目。贸然发布可能导致项目后续支持不足,损害用户体验。

面对这些现实制约,DeepSeek 选择了与现有开源项目(特别是 vLLM)紧密合作的路径,以更灵活、更易于集成的方式分享其技术积累。具体策略包括提取可复用的独立特性,将其模块化后作为独立的库贡献出来;以及直接分享优化细节,向 vLLM 等项目贡献设计思想、实现方法甚至具体的代码补丁。

这一合作策略获得了社区的普遍理解和积极响应。vLLM 项目官方账号在社交平台 X 上明确表示支持,认为 DeepSeek“以正确的方式开源引擎”,即将改进带回社区使人人受益,而非创建一个独立的仓库。技术社区的讨论也倾向于认为,这种分享“know-how”和可集成模块的方式,比发布一个难以维护的代码“僵尸”更有价值。

图丨相关推文(来源:X)

社区对 DeepSeek 贡献内容的期待值很高。此前已有分析指出,vLLM 在吸收 DeepSeek 2 月的“开源周”所公布论文中的部分优化后,处理 DeepSeek 模型的性能已有显著提升(约 3 倍)。

图丨不同 LLM 服务框架中每秒令牌数的性能提升,突显了 vLLM 中的优化。(来源:Red Hat)

而根据 DeepSeek 此前公布的推理系统内部测试结果,每个 H800 节点在预填充期间平均吞吐量达到 73.7k tokens/s 输入(包括缓存命中),或在解码期间达到 14.8k tokens/s 输出。相比之下,有开发者使用 vLLM 在高并发下,使用 sharegpt 数据集时基准测试约为 5K total tokens/s,随机 2000/100 测试达到 12K total token/s 的吞吐量。这表明推理性能优化领域仍有巨大提升空间。

值得注意的是,DeepSeek 在公告中特别澄清,本次宣布的开源路径仅针对其推理引擎代码库。对于未来模型发布,公司将继续秉持开放协作的态度,致力于在新模型推出前与社区及硬件伙伴同步推理优化工作,确保社区能在模型发布首日(Day-0)获得最先进(SOTA)的推理支持(或许这项工作也是为不久后到来的 R2 做铺垫)。其最终目标是构建一个同步生态,让前沿 AI 能力能在多样化硬件平台上无缝落地。

“特别声明:以上作品内容(包括在内的视频、图片或音频)为凤凰网旗下自媒体平台“大风号”用户上传并发布,本平台仅提供信息存储空间服务。

Notice: The content above (including the videos, pictures and audios if any) is uploaded and posted by the user of Dafeng Hao, which is a social media platform and merely provides information storage space services.”