自从被AI换了身体,做一个女装大佬无压力

独家抢先看

“我眼瞅自己跳着芭蕾的视频,看到那一抹妖娆妩媚,惊叹自己还有这样一面。”

听着王大柱的自述,哥几个张大了嘴巴。要知道,面前这位,可是身高199,体重210,胸肌、腹肌全套配的铁血男儿。

猜猜看,壮汉咋习得的这一身绝技?

A:芭蕾舞女神附体。

B:路遇绝世高人,拜师学艺。

按常人逻辑来看,这答案,显然是B。不过,像王大柱这么难驯化的“品种”,走寻常路线是不行滴。

所以,正确答案是A。之所以称之为“附体”,这其实是人体深度伪造技术呈现的效果。

“深度伪造”(Deepfake)是英文“deep learning”(深度学习)和“fake”(伪造)的混合词,即利用深度学习算法,实现音视频的模拟和伪造。顾名思义,人体深度伪造技术就是指通过AI模型算法将目标人物的整个身体替换成另一个人。

看脸时代已过,AI“邀”你来看身体

上帝给了我们张独一份的面容和一具“量产版”的躯体。

故事中,上帝捏出的亚当和夏娃是人类的初始形态,接下来就是批量复制。但这并不影响被复制出的小人们性情各异,自然穿着、行为也都有所不同。

因此,相比AI换脸,全身深度伪造想要做得好,不光是需要完美复制,更多的是通过算法、数据的分析重构人体,进而将一个人的外在气质嫁接过去。

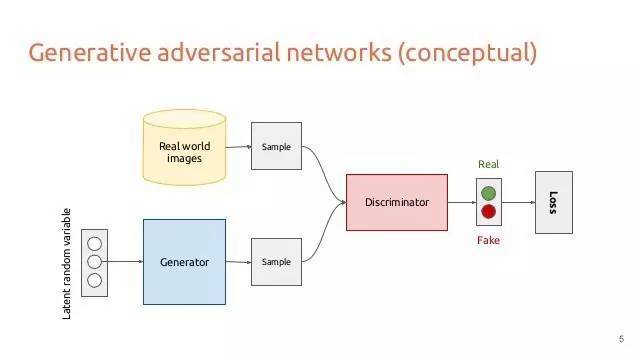

全身深度伪造技术使用生成对抗网络(GANs)创造深度伪造视频。这是一种能“教会”计算机胜任人类工作的有趣方法。一个好的对手能让你成长更快,而GANs背后就是“从竞争中学习”的思路。

那么,GANs是如何工作的?

GANs中包含两个相互竞争的神经网络模型。一个网络称为生成器(generator),能将图像或视频作为输入并生成样本;另一个网络称为鉴别器(discriminator),能接收生成器数据和真实训练数据,是用于得到能正确区分数据类型的分类器。

所谓机器训练过程,其实是生成器和鉴别器的“交锋”过程。在这一阶段里,前者依靠数据库不断创造出基于样本要求的“高仿制品”,后者充当检验真假的“警察”。

随着“交战”进行,鉴别器越来越难以区分生成器给到的“产品”真假,而这个过程也会产生很多不同程度的新合成样本,它们被用于创建逼真的合成图像和视频。

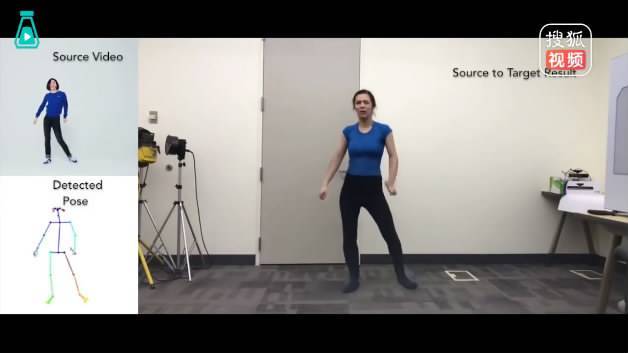

2018年8月,美国加州大学伯克利分校的研究人员在网上发布了名为《人人皆为舞王》的视频,展示了深度学习算法实现动作转移的方法。

视频中,专业舞者的动作被转移到业余爱好者的身上,瞬间让普通人get到开挂技能。

同年,由德国海德堡大学图像处理合作实验室(HCI)和科学计算跨学科中心(IWR)的计算机视觉教授比约恩·奥默尔领导的研究小组,发表了一篇关于教授机器以逼真形态渲染人类身体运动的论文。

2019年4月,日本人工智能(AI)公司Data Grid开发了一种AI应用,它可以自动生成不存在的人的全身模型,并可以将其应用到时尚和服装行业。

加州大学伯克利分校的研究人员称,目前这项技术仍处于早期阶段,人体深度伪造还没有办法做到像人脸识别那样呈现真假难辨的拼接效果,这其中涉及到的不光是对身体动作的复刻,更是对步态检测、惯性捕捉、微姿态记录等技术的融合使用提出更高要求。

直到目前,人体深度伪造技术看上去都是一副“人畜无害”得样子。

不过,凡事都有其两面性,在不法分子眼里,人体深度伪造技术在色情业、广告营销、网络欺诈等领域可谓“大有所为”。

黑化的高科技,骗子的“红利”

多了个身体,深度伪造技术的“修为”更上一层楼。在凡事都讲求个“眼见为实”的今天,杀伤力反而更大。

2018年,CNN驻白宫首席记者吉姆·阿科斯塔(Jim Acosta)在Infowars的编辑保罗·约瑟夫·沃森(Paul Joseph Watson)上传的一段视频片段中,阿科斯塔似乎在猛推试图拿走其麦克风的白宫工作人员。

实际上,由C-SPAN播放的原始视频与沃森上传的视频内容截然不同。

沃森坚持认为,自己并没有篡改视频内容,由于上传时视频的自动压缩导致与原始视频相比缺失了几帧,而就这几帧恰好造就了上面的那句。

因此,沃森差点被自己送去吃牢饭(没错,这事阿科斯塔曾考虑起诉沃森)。

Emm~心疼三秒钟

这种深度伪造无需什么技术含量,即可扭曲一段视频的含义,抹黑一个人。这可以是无意间发生的,但做到真的很容易。

不用多久,傻瓜式操作的人体深度伪造应用便会问世。网络安全公司Deeptrace通过构建基于计算机视觉和深度学习的工具证实了这一点。

这个AI工具,像是个基于媒体的“造人神器”,它可以操纵任何类型的合成视频,随机合成其中一个或几个演员的全身、面部图像和音频。

Deeptrace安全人员称,我可以制作一段杰夫·贝索斯(Jeff Bezos)的深度伪造视频,他说亚马逊的股票正在下跌,想想做空亚马逊股票可以赚到多少钱。当你控制住它传播的时候,损害已经造成了。

别有用心的组织利用深度伪造技术对政要、记者等人物进行篡改,在发生重大事件时可能会混淆视听,影响新闻报道的真实性,造成社会舆论混乱,危害社会稳定。

若能达到无缝拼接,很难看出破绽......可怕,谁快来收了这妖孽?

抱歉,目前在科技行业中还没有找到根除深度伪造的共识方法,许多不同的技术正在研究和测试中。其中包括:

1、调查各类镜头的数字水印,以识别深度伪造内容

2、使用区块链技术建立信任体系

3、创造“AI神探夏洛克”,即取样某些卷积模型,然后在视频中寻找异常

4、通过基于API的监控系统看到深度伪造视频的创建、上传和共享过程

尽管这些办法都可侦测人体深度伪造的内容,但较高的准确度依然聚焦在面部识别,而探测深度伪造技术的下一件大事,是“软”生物特征签名。

无论是面部微表情,还是身体动作、体态,都是独一无二的。加州大学伯克利分校的研究员舒迪·阿加瓦尔(Shruti Agarwal)使用这类软生物识别模型,来确定这种微小变化是由视频人工创建的。

另一边,在于短期内,推广虚假信息和其他有毒、煽动性内容对主要平台来说是有利可图的,因此激励机制也完全不一致。

网易易盾实验室告诉雷锋网,通过深度伪造技术,人体动作行为可以再生成,恶意改造可能会严重侵犯个人隐私,引起的传播效应会对个人造成负面社会影响,并且,这一系列技术给司法鉴定带来更大挑战。

有研究人员献计:阻止深度伪造的全面法律可能反而会被误导。在现有涵盖诽谤和版权的法律情况下,应支持造福社会的合成媒体应用,同时资助研究开发工具来检测深度伪造内容,并鼓励初创企业和其他公司也这样做。

参考来源:网易智能公众号;CSDN

更多精彩内容请关注雷锋网官网网络安全频道或雷锋网旗下为题

“特别声明:以上作品内容(包括在内的视频、图片或音频)为凤凰网旗下自媒体平台“大风号”用户上传并发布,本平台仅提供信息存储空间服务。

Notice: The content above (including the videos, pictures and audios if any) is uploaded and posted by the user of Dafeng Hao, which is a social media platform and merely provides information storage space services.”