智驾,英伟达“急了”

作者丨李赓

头图丨视觉中国

昨天(1月7日)早上,黄仁勋再次用自己的CES主题演讲引爆了科技圈。

在这场时长1个半小时的发布会中,绝大数人最关心的可能是全新的50系显卡和直接将Mac Mini从“桌面盒子”AI王座上赶下的Project DIGITS。但如果整体审视发布会各部分内容和时长,就会发现“智驾+机器人”显得尤为突出。

这一变化也反映出AI巨头英伟达的最新策略——乘着大模型端到端的东风,在智驾领域和机器人分别发起“追击战”和“攻坚战”,再次尝试将自己的影响力通过数字世界覆盖现实世界。

“停滞”的硬件,英伟达不再绝对领先

严格来说,在本届CES上,英伟达并没有为智驾带来任何新硬件。从黄仁勋重点展示的Thor处理器到PPT上“一闪而过”的Hyperion 9智驾平台,实际上都是2022年秋季的GTC发布的“旧产品”。

黄仁勋展示Thor处理器,最大的意义可能是向全行业证明真的开始量产了

更重要的是,截至目前Thor仍没有后继型号发布,完全打破了英伟达智驾平台过往1~2年就换代的稳定节奏(英伟达2017年发布Orin,2019年发布Atlan后取消项目,2022年发布Thor)。

英伟达之所以“不着急”,很大程度上也是因为Thor的前辈Orin性能足够强大,后者的双芯片智驾平台解决方案能够提供超过500TOPS的AI算力。在目前全球各个应用中的智驾平台方案中,仍处于第一梯队(特斯拉的HW4.0平台大致是300~500TOPS,华为的ADS平台算力也曾达到400TOPS)。

而此次终于要量产上市的Thor,英伟达也一直没有公布具体参数细节,但可以明确其算力为1000TOPS级别,且相较于上一代的Orin芯片可以实现8倍的能效比。也就是一颗Thor很可能顶4颗OrinX,同时耗电还少一倍。

有这么强大的新硬件,为什么英伟达在这两年不将其推向市场?这个问题一直是个悬案,但大概率与英伟达Blackwell架构上的设计缺陷(黄仁勋自己在公开采访中承认是英伟达自己的失误),也遗传到了使用同样架构的Thor芯片中。

但即便Thor真的能顺利量产并且被实车搭载,英伟达在智驾芯片上的一家独大也已经无法复现。

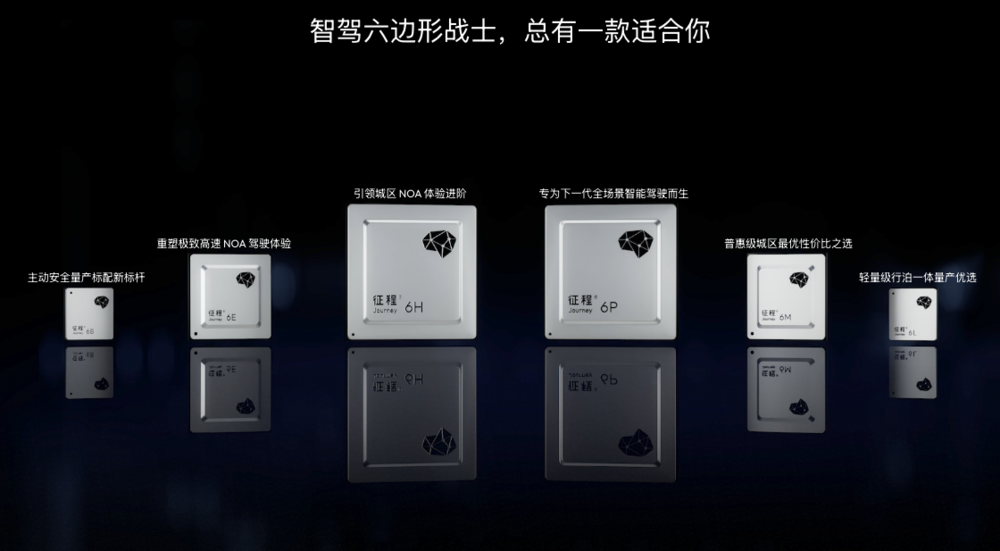

就拿目前已经将芯片塞进了理想、去年4月全新发布了新产品“征程6”系列并且给出了全部性能参数的地平线来说,其最强的“征程6P”芯片性能标称560TOPS,双芯解决方案同样能够超过1000TOPS。按照地平线官方的规划,这颗芯片结合其全场景智能驾驶解决方案SuperDrive在2025年第三季度发布。

这种“被围剿”现象的背后,其实是英伟达多年AI发展的“通病”:虽然其训练侧领先性毋庸置疑,可一旦某个行业或者场景走向成熟,基于GPU架构的各种解决方案往往会被更专用化的ASIC和SoC方案所顶替,反而吃不到行业AI广泛应用的红利。

英伟达打算拿什么主宰端到端?

去年年初,特斯拉采用“端到端”方案的FSD V12一经部署,在行业内实现了标杆效应,带动了 “蔚小理” 等车企以及华为、地平线这样的厂商纷纷转向,加码 “端到端” 自动驾驶技术。

这条全新路线简而言之,就是通过架构和机制的改变,打破过去自驾行业人类标注数据的瓶颈,用更弱的监督和更多的数据,在自动驾驶这个方向复现这几年大语言模型的“智能涌现”。

换言之,训练算力或者说整个数据中心的规模、以及能够获得的优秀数据规模,就决定了“端到端”的表现高低。

黄教主:皮一下很开心(身前的“盾牌”实际上是一台NVL72服务器中所有英伟达芯片拼成)

在这两点中,英伟达数据中心产品的强大无需多言,但数据侧则一直是其弱点。虽然英伟达智驾生态合作伙伴众多,但各家的数据大多只是服务于自己,英伟达自己虽然有车队和工程师,但体量终究无法与全球数百万用户的特斯拉相比。

甚至可以这样说,特斯拉之所以要费劲自己构建一套从智驾芯片到数据中心芯片的硬件网络,本质都是为了独立挖掘和守护海量数据的价值。

那么有没有什么办法能够在不卖车的情况下,生成海量的驾驶训练数据呢?一个最简单的思路就是用机器去生成。本就在游戏和专业虚拟化领域十分强大的英伟达,在这个方向上,进行过不止一次尝试。

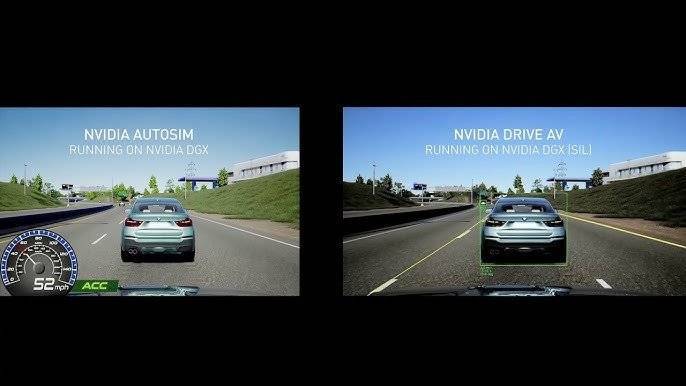

AutoSim怎么看都像是一个做工粗糙的汽车游戏

就拿我所知道最早的一次来说,英伟达早在2018年,就曾公布过一套能够利用智驾解决方案和云端算力对自动驾驶场景模拟、名为 “AutoSim” 的系统。后来数年英伟达数次从生成数据类型、生成数据精细程度对模拟进行过升级,但始终无法兼顾“无需人监管生成数据”和“生成数据有训练价值”这两个要点。

同样的问题,也是目前中国智驾功能表现体感提升困难的关键(相比特斯拉在美国本土的流畅体验。中国道路环境的变数实在太大,尤其是各种对象对交通规则的不遵守,造成了训练数据的需求量极大)。

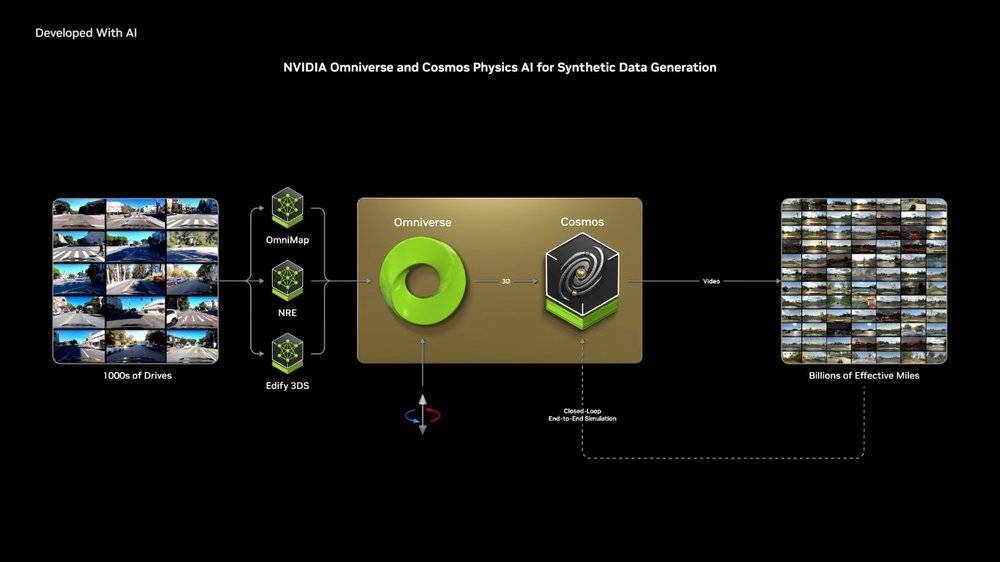

为了突破这个障碍,英伟达本次在发布会上提出了一个全新的解决思路:先投入海量资源,先打造一个靠谱的世界模型(通过大量图像、音频、视频和文本数据训练,让机器对世界运作方式能够进行推理),然后部分结合现实司机驾驶数据,数字孪生相关的各种资源,最终生成几何倍数于真实数据的虚拟驾驶数据。

而这个世界模型,就是英伟达在本次发布会上首次亮相的Cosmos。根据官方公布的信息,最大的Cosmos模型参数规模大概140亿(也就是14B),用2000万小时的真实世界人类互动、环境、工业、机器人和驾驶数据训练而成。

这个新方案的优点用黄仁勋自己的话来说:这个方法仍然需要真实的司机收集数据,但几千个司机的数据完全能够在简单的命令下生成数十亿公里的新数据。

听起来比较抽象,黄仁勋在现场用视频展示了这个解决思路的几种应用思路。

其中有辆车是不是有点眼熟

第一种是利用现实世界中道路的核心物理信息,利用世界模型和数字孪生的能力进行训练数据的生成。同样的一个现实路口除了基本走向,其他一切信息都可以通过生成改变,包括国别、时间、天气、附近的交通对象等等(不过可能,左右舵国家可能需要分别建立真实数据库)。

第二种相比第一种要更重要一些,是对障碍物的模拟,英伟达的这套解决方案支持在生成的过程中,直接从数字孪生数据库中调用各种障碍物,并且随意摆放,直接虚拟出一个极为复杂的施工路段。当然,从目前的障碍物列表来看,这个应用后续还要升级,对中国场景做出更多适配(例如增加高速移动的小电驴、低速移动的共享单车、看起来像是车但更野蛮的老头乐,以及不按红绿灯的行人等等)。

如果前两种还算是比较“精工细作”,那么利用直接用文本描述让Cosmos生成视频的过程显然才是最让人惊讶的,你可以把它理解为一个物理层面更靠谱的“文生视频”能力。

就拿上面这个演示来说,实际输入的英文指令翻译过来的大概意思是“行车记录仪捕捉到了夜间交通繁忙、雾蒙蒙的高速公路的景象。场景被闪烁的红色刹车灯和微弱的蓝色车头灯照亮。浓雾遮住了道路上的部分车辆。突显了有限的能见度和具有挑战性的驾驶条件。”Cosmos几乎是在一瞬间就生成了6个不同摄像头视角的视频画面(第一排的6个画面,仔细看甚至每个画面之间的对象关系也是没问题的,随着车辆前行旁边的车会出现在对应的摄像头视角中)。

功能看起来相当美丽,但还存在不少疑问:例如上面提到的能否在模拟意外场景的功能中,升级出足够贴合中国场景的素材?Cosmos和Omniverse的相应能力如何向客户提供?如果车企自身在本地没有足够的英伟达GPU资源,能否在云上架设整套系统?还有就是这些训练出来的画面,能否高效自动地归集和学习,进一步降低训练的成本等等。

按照英伟达过往的策略,必然会一块块补上剩下的拼图。

可以肯定的是,全新方案“低投入高回报”的特性,将为目前进度相对落后的车企和供应商,提供一个难得的“追击”机会。

写在最后

从2015年正式做智驾业务至今,英伟达已经在这个领域探索了10个年头,成长只能说不尽如人意。就拿最直白的营收来说,“汽车和机器人”业务在上个季度营收中仅仅占到1.2%,其中大部分还是中国新势力车企所贡献。

造成这个结果的核心,还是AI从数字世界向现实世界跨越的路途中,仍存在巨大的鸿沟。未来如果英伟达真的能够继续扩充其世界模型,让其能够更精准、更合理的模拟世界,其所打开的可能性不会止步于智驾,而是会快速蔓延至机器人等更多可以落地的现实行业和现实应用中去。

如何完成这一步关键的“脱数向实”,将成为英伟达接下来发展的一个核心看点。

“特别声明:以上作品内容(包括在内的视频、图片或音频)为凤凰网旗下自媒体平台“大风号”用户上传并发布,本平台仅提供信息存储空间服务。

Notice: The content above (including the videos, pictures and audios if any) is uploaded and posted by the user of Dafeng Hao, which is a social media platform and merely provides information storage space services.”