DeepSeek-V3:美国芯片封锁的“意外”产物?

独家抢先看

继电动车、消费品之后,中国团队又在AI领域上演了一出“成本屠夫”的好戏。

用两个月、600万美元,就能训出一个能跟ChatGPT掰手腕的AI模型?Deepseek用实力演绎了“四两拨千斤”是什么意思。

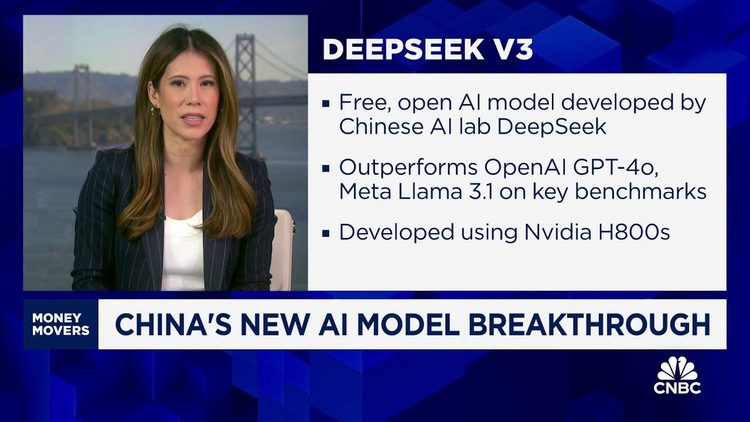

幻方量化旗下的DeepSeek公司宣布发布全新系列模型DeepSeek-V3首个版本,并同步开源。他们仅用2048块H800显卡、耗时两个月,就训出了一个6710亿参数的DeepSeek-V3。相较于Meta训练参数量4050亿的Llama 3,用了16,384块更强的H100显卡,花了54天。Deepseek的训练效率提升了11倍。

这事儿一出,连CNBC都坐不住了。在最新报道中,记者亲自上手测试后惊呼:“这模型的能力完全能和OpenAI掰手腕”。

DeepSeek-V3在技术圈收获的关注和讨论,堪比游戏界的《黑神话:悟空》,其影响力甚至让OpenAI CEO奥特曼坐不住了,发推特暗戳戳说“复制总比创新容易”。而市场也开始担心:要是人人都能用这么低的成本训练AI,那些靠卖显卡发财的“卖铲人”可就要慌了,英伟达股价甚至一度应声下跌。

不过OpenAI另一位联合创始人Karpathy表示,这并不意味着前沿LLM不需要大型 GPU 集群,而是说明AI领域的数据和算法还有很多黑科技等着被挖掘。

那么,Deepseek是如何做到这种惊人的训练效率的?答案就在他们独特的技术方案中。

1

少即是多:DeepSeek-V3 高效 AI 训练的新方法

DeepSeek-V3的训练效率水平揭示了其巧妙的训练方法——关键在于更聪明地工作,而非单纯依赖更多硬件投入。

具体来看,Deepseek采用了由2048块Nvidia H800 GPU组成的集群,每块GPU通过NVLink互连实现GPU间通信,并通过InfiniBand互连实现节点间通信。在这种配置下,GPU间通信速度相当快,但节点间通信则不然,因此优化是提升性能和效率的关键。DeepSeek实施了数十项优化技术以降低其 DeepSeek-v3 的计算需求,但几项关键技术促成了其令人瞩目的成果,包括:

MoE

不同于单一庞大的神经网络,DeepSeek-V3 采用了MoE架构(Mixture of Experts)。MoE的核心理念可以这样理解:有一群各个领域的专家,共同协作解决问题。面对用户的任务,系统会智能地识别出最适合的专家来处理,通过稀疏激活机制大幅减少计算量。

MoE与密集模型(Dense Model)在训练成本上存在显著差异。尽管MoE模型通常包含更多的参数,但由于其稀疏激活机制,每次仅激活部分专家网络,从而在相同计算预算下实现更大的模型容量和更高的性能。这使得 MoE 模型在预训练阶段比同等规模的密集模型更高效,能够以更低的计算成本达到相似或更优的性能。

DeepSeek-V3采用了多个小型专家的MoE结构设计,而非像Mixtral那样使用少数大型专家。这一设计让模型在总参数量达到671B的同时,实际运行时只需激活37B参数,大大提升了模型的稀疏性。

MLA

DeepSeek-V3的另外一个创新是多头潜在注意力(Multi-head Latent Attention,简称 MLA),这是大型语言模型中常用注意力机制的增强版本。

MLA是DeepSeek独创的结构,在DeepSeek-V2中提出,其核心概念可以这样理解:在阅读复杂内容时,我们的大脑不仅仅处理每个单词,还会捕捉到其中的联系和暗示。MLA让DeepSeek-V3能够类似地同时关注不同部分的信息,从而获得更丰富的理解。这在连接信息点时特别有用,比如解决复杂的数学问题或编写代码。

FP8

Nvidia H800是专为中国市场定制的、性能较其原型Nvidia H100大幅削弱的版本。H800限制了集群卡之间的互连速度:约400GB/s,而H100可达到高达900GB/s。

这种性能瓶颈,使得降低计算和通信成为降低训练成本的关键,DeepSeek 运用了 FP8 混合精度框架,实现了更快的计算速度和更低的内存占用,同时不牺牲数值稳定性。关键操作如矩阵乘法以 FP8 进行,而敏感部分如嵌入层和归一化层则保持较高精度(BF16 或 FP32)以确保准确性。这种方法在减少内存需求的同时保持了稳健的准确性,相对训练损失误差始终控制在 0.25%以内。

FP8精度的使用是DeepSeek-V3的重大创新,V3是第一个成功使用FP8混合精度训练得到的开源大参数MoE模型。这意味着它所需的内存更少,并能显著加快计算速度。

Dualpipe

DeepSeek团队开发的DualPipe算法改进了流水线并行性能,通过计算和通信阶段的重叠设计,有效降低了跨节点专家并行带来的通信开销。同时,他们优化了跨节点通信内核,提高了带宽利用率,减少了通信所需的计算资源。DualPipe算法显著缓解了训练瓶颈,尤其是MoE架构所需的跨节点专家并行性,这些优化使得团队无需使用成本较高的张量并行技术就能完成V3的训练。

1

算力利空?硬件限制催生软件创新

在外界看来,DeepSeek在芯片性能较差、资金和GPU使用时间更少的情况下,依然能够取得更好的表现。考虑到他们所面临的 AI 硬件资源的限制,这一成就尤为值得关注。

2022年10月,为阻止中国成为人工智能与计算领域的超级大国,美国对中国实施了广泛的芯片出口限制:这是中美之间持续进行的“芯片战争”中的众多打击之一。

这些芯片限制的初衷,目的是想通过掐断中国获取顶尖硬件的渠道来限制中国在AI领域的发展。为应对新规,并维持在中国市场的竞争力,英伟达推出了针对中国市场的“定制版”H800芯片。

DeepSeek-V3的成功,可能预示着一个有趣的转折:软件创新正在突破硬件限制。如果他们的技术报告属实,这或许意味着中国在芯片竞争中已经占了上风。理论上受限制的芯片应该会限制他们的研发突破。但事实上,Deepseek在研究和产品方面都取得了重大进展,证明了另辟蹊径的可能性。

正因为中国工程师拿不到最好的硬件,客观上促进了中国工程师在算法、架构、训练策略等软件层面的创新,“被迫”开发出新方法来充分利用手头的资源,甚至突破了传统所认为的极限。反而逼出了更多软件层面的创新,而不是单纯靠硬件堆砌。

这反倒让美国限制中国的战略变得很讽刺。如果软件技术越来越强,那用什么硬件可能都不重要了。

不过,DeepSeek V3在技术成就之外也引发了一些争议,用户发现该模型会在某些情况下声称自己是ChatGPT。

一种可能的解释是,DeepSeek-V3的训练数据集中可能混入了ChatGPT的生成内容,导致模型在学习过程中产生了混淆。另一种可能性是,DeepSeek在训练过程中使用了GPT模型进行知识蒸馏,即利用GPT模型的输出作为 “教师信号”来指导DeepSeek-V3的学习。

一位大模型从业者告诉硅星人,“数据蒸馏对成本的影响不大,如果只是靠数据蒸馏,为什么其他人没做到呢?Deepseek一定是靠自己独特的训练和工程实践方法。”

在压力和限制之下,创新往往会以意想不到的方式涌现。中国工程师们正在用实际行动证明,即便面临硬件限制,依然能在AI领域做出令人瞩目的成果。这种由需求驱动的创新,很可能继续带来一些突破性的思路。

对于人工智能行业而言,DeepSeek-V3 预示着大型语言模型开发方式可能迎来范式转变。通过巧妙的工程设计和高效的训练方法,前沿的人工智能能力或许可以在不依赖庞大计算资源的情况下实现。随着DeepSeek-V3的出现,市场变得更加多元化,为开发者、内容创作者乃至小型初创企业提供了更多选择。

当然,如果未来OpenAI、Meta等公司利用更庞大的算力集群训练出性能更为卓越的模型,行业可能会再次掀起对超大规模预训练的热潮。

届时,行业可能会重新回到算力军备竞赛的老路,AI领域的“卖铲人”将继续成为最大赢家。

“特别声明:以上作品内容(包括在内的视频、图片或音频)为凤凰网旗下自媒体平台“大风号”用户上传并发布,本平台仅提供信息存储空间服务。

Notice: The content above (including the videos, pictures and audios if any) is uploaded and posted by the user of Dafeng Hao, which is a social media platform and merely provides information storage space services.”