干翻英伟达,明年将是转折吗?

独家抢先看

就在近几天博通因为ASIC大涨,英伟达股价却从11月21日突破新高之后一直震荡向下。

目前,博通市值高达1.03万亿美元,在半导体芯片公司中仅次于3.29万亿的英伟达。市场对博通及ASIC的关注,甚至盖过了英伟达即将量产发货的Blackwell。

下游科技大厂对英伟达的抵抗,终于来到高潮了吗?对于国内的AI产业又有什么启示?

01

英伟达时刻重现

上周四盘后,博通公布第四财季及全年财报。除了各项收入指标全面增长,其中最大的亮点是,2024年半导体业务收入中有122亿美元来自AI收入,同比增长220%,2倍的增量主要得益于领先的人工智能芯片XPU和以太网网络产品组合。

同时博通还透露,目前正在与三个非常大型的客户开发AI芯片,预计明年公司AI芯片的市场规模为150亿-200亿美元。

现在市场逐渐意识到,大型云服务商们对博通定制人工智能芯片和网络设备的需求旺盛,开始对一直统治AI加速芯片市场的英伟达构成了威胁。

这层理解,直接驱动博通在连续两个交易日里上涨了38%,成为第二家万亿市值的芯片公司。上一次大市值芯片公司能出现如此大的涨幅,还是去年5月份公布超预期业绩指引的英伟达,随后也走上了万亿市值之路。

历史何其惊人的相似,博通和英伟达的叙事里有一个共同点,那就是AI芯片需求的爆发式增长,而英伟达却是博通叙事里的那条“恶龙”。

众所周知,英伟达的卡非常贵,还很难拿货。对于大型云服务商来说,替换成本不仅仅是自研芯片那么简单,而是算力基础设施投入运营,提供云服务的综合成本(TCO)优化,这直接影响了云服务商之间的竞争。

因此,过去正当科技大厂们哄抢英伟达芯片的同时,他们还纷纷下场自研芯片,谷歌找到博通开发TPU,亚马逊和Marvel达成五年合作协议,微软在过去一年已经实现了“CPU+GPU+DPU”全面自研。

这里,巨头们的目标是一致的,即优化成本的定制化芯片需求,而博通提供的解决方案正好能够解决燃眉之急。

ASIC是一款高度定制化的芯片,行业称之为专用集成电路,跟通用GPU比起来,ASIC被应用于特定设计和制造设备里,执行和优化某项功能,比如更快的处理速度和更低的能耗。

一般下游大厂有需求,找芯片设计公司帮忙做出来,自己开发周期长,但一旦做出来之后不用再给英伟达交那么多税,专门应用于自己的算法模型使用即可。实际的例子,就是博通帮助谷歌开发的TPU系列。

芯片设计公司在XPU的合作模式中承担着越来越重要的角色,不仅接管了前后端的设计外包,有的甚至能把流片和封装也干了,最终帮助大厂在算力性能和成本上达成平衡点。

在ASIC市场中,目前博通以55%-60%的份额位居第一,Marvell以13%-15%的份额位列第二。

国内做ASIC芯片也有这么几家,寒武纪、云天励飞、北京君正以及国科微。

近期连续上涨,市值已经超过2800亿的寒武纪,公司的AI芯片走的就是ASIC路线,2016年即推出了首款NPU。据悉,公司正在研发的思元590,直接对标华为的昇腾910B和英伟达H100。

虽然公司目前业绩难以匹配上估值,但从三季度存货和预付账款大幅增长的趋势可以看出未来积极的生产投入,随着先进制程芯片自主可控的需求加强,未来收入放量确定性高。

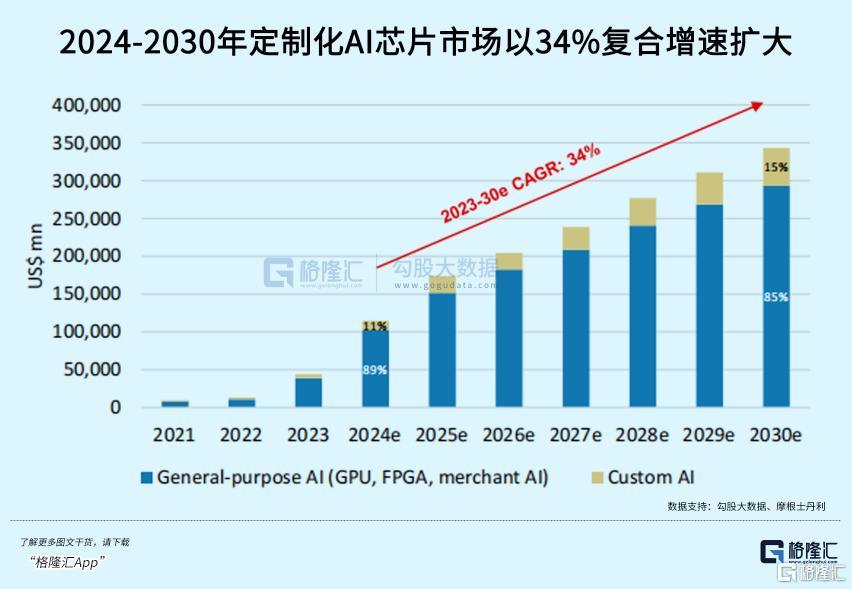

有机构预计,客户定制化的AI ASIC的增速预计将超过GPU计算。

除了英伟达以外,博通目前在芯片领域里占据了最好的生态地位。

这是因为,AI基建并不只是搞定芯片那么简单。

英伟达统治AI训练市场的王牌,除了芯片,还有CUDA和NV LINK,前者与芯片高度适配的软件开发工具,后者则是能提供高速低延迟工作环境的专用网络协议。

定制化芯片摆脱了云服务商对CUDA的依赖,但博通出色的不止是ASIC,网络专用协议和相关芯片IP也一应俱全,这使得博通有能力帮助客户搞出XPU+超高速互联集群服务器来。

而英伟达之所以下跌,就是因为市场正在权衡未来英伟达GPU需求面临的挑战。

其一,Blackwell能否在未来继续统治市场,这款芯片将在今年四季度小幅出货,明年预计将成为英伟达主力产品。但随着大型科技公司定制化ASIC成为常态,以及推理计算需求的成倍增长,英伟达GPU可能无法继续统治推理市场。

其二,英伟达面临的另一个阻力,是过去两年惊人的业绩增长所设定的高标准。

FactSet调查的分析师普遍认为,2025年英伟达营收将增长55%,达到1914.5亿美元,相比之下,预计2024年英伟达营收将增长一倍以上,达到1233.7亿美元。

市场对AI芯片竞争格局的认知正在重新修正,明年可能就会有巨大的变化。

博通定制化ASIC方案崭露头角,跟当年台积电挑战传统IDM,有些异曲同工的。

02

明年将是推理之年

ChatGPT面世两年多以来,AI的主战场正从训练端转向一个规模更大、竞争更为激烈的领域:推理。

近月,AI应用端发生了许多令人印象深刻的事件。

Open AI连续12场带着震撼产品更新的发布会正在进行中,与此同时谷歌近期也大招频出,Gemini 2.0、Veo 2、量子芯片......谷歌高管给Gemini 2.0的定位是:面向智能体时代的AI模型。

时间再回到三个月以前,Open AI 发布o1系列,通过强化学习,把LLM的逻辑推理能力又提升了一个级别。并且,随着更多的强化学习(训练时间计算)和更多的思考时间(测试时间计算)投入,o1的性能不断提高。

(Open AI)

Open AI是Scaling Law的簇拥者,因为正是这条金律吸引来无数资本的注入,而Open AI希望能一直代表它。

但如今的数据犹如模型训练的化石燃料,终将是会耗尽的,这是大模型竞赛从预训练转向推理的重要原因,近期前Open AI高管Ilya Sutskever公开演讲谈及这一点,其预计,下一代AI模型将是真正的AI Agent,且具备推理能力。

而此前微软CEO纳德拉也强调,未来将会涌现出新的Scaling Law,将按照测试或者推理时间来进行定义。

所以o1不只是一次简单的升级,而表明整个行业正在探索一条全新的游戏规则,即模型“思考”的时间越长,就越能提供准确的答案。

在这个尺度上,推理场景将产生巨大的算力需求,并且推理成本有望随着各种AI原生应用的飞轮效应快速地下降。

巴克莱的另一份报告则预计,预计AI推理需求将占通用人工智能总计算需求的70%以上,甚至达到训练计算需求的4.5倍。

10月份,AI初创独角兽Anthropic推出了Claude 3.5 Sonnet在性能测试上,击败了Open AI的o1。并且,Sonnet还引入了自动化交互的操作,让AI能够直接操作电脑执行复杂指令。

在移动端,国内初创公司智谱推出的AutoGLM,绕过手机操作系统,在UI界面模拟用户操作,从而实现“接管手机”。而且根据媒体爆料,Open AI也将在明年1月推出Agent“Operator”。

谷歌呢?当然有了。从手机、AR眼镜,浏览器,再到专门面向开发者和科研场景,都在Gemini 2.0基础上做出了Agent。

细想一下,两年前的ChatGPT仅仅只是个聊天机器人,而作为极为复杂的多模态交互推理场景之一,为了拆解复杂指令,AI Agent需要能够从用户终端的数据里学习和思考,以做出准确的操作,这恰恰是推理模型接下来精进和延申的方向。

而数据飞轮得以转动的关键在于,开发合适的软硬件来满足用户的需求。

今年下半年“AI+应用”的商业化赛道再次瞩目,Applovin、Shopify、Palantir等不同赛道的美股公司,受益于AI带来的业务爆发,股价持续走强。

国内也重点着力于AI应用的发展,字节大模型虽然起步晚,但后来居上,目前豆包DAU接近900万,增速超过15%,位居全球第二。不仅打出了多款应用组合,还投入到了AI硬件中,积极寻找C端场景。其他互联网巨头如百度、小米也开始投入到AR眼镜的开发里。

(Ola Friend;官网)

03

AI渗透率即将跨越鸿沟?

机构预测,英伟达GPU目前在推理市场中市占率约80%,但随着大型科技公司定制化ASIC芯片不断涌现,这一比例有望在2028年下降至50%左右。

但,ASIC的崛起并不意味着GPU的衰退。这两种技术可能将长期共存,为不同需求场景提供最佳解决方案。

可以肯定的说,AI目前还没有达到我们期待的样子,但推理技术的进步开始支持其走向终端,未来类似的“英伟达时刻”将会更多出现在推理端。

不过,欲戴王冠必承其重。譬如Arm,在2月份给出了乐观的预测,并表示这“只是人工智能繁荣的开始”。股价在接下来的三个交易日内飙升93%,但此后股价经历了较大的波动,目前已较7月份的高点下跌逾20%。

而过去一周,博通2025财年每股净收益的预期上涨了12%。并非每一个“英伟达时刻”都能带来持续增长。(全文完)

“特别声明:以上作品内容(包括在内的视频、图片或音频)为凤凰网旗下自媒体平台“大风号”用户上传并发布,本平台仅提供信息存储空间服务。

Notice: The content above (including the videos, pictures and audios if any) is uploaded and posted by the user of Dafeng Hao, which is a social media platform and merely provides information storage space services.”