打开AI黑箱:DeepMind开发的新工具可揭示大模型内部秘密

独家抢先看

人工智能已经在药物研发和机器人技术领域取得了突破,同时正在彻底改变我们与机器和网络的互动方式。然而,唯一的问题是我们并不完全知道它是如何运作的,也不清楚它为何如此有效。虽然我们对其有一定的了解,但细节过于复杂,难以理清。这是一个潜在的问题:如果我们在不了解其潜在缺陷的情况下将 AI 系统应用到诸如医疗这样高度敏感的领域,可能会导致严重后果。

Google DeepMind 的一个团队专注于研究所谓的“机制可解释性”(mechanistic interpretability),他们一直致力于开发新方法来帮助我们“揭开盖子”。7 月底,该团队发布了一款名为 Gemma Scope 的工具,旨在帮助研究人员了解 AI 在生成输出时发生了什么。希望通过更深入地了解 AI 模型内部的工作原理,我们能够更有效地控制其输出,从而开发出更优质的 AI 系统。

“我希望能直接查看模型内部,判断它是否存在欺骗行为,”Google DeepMind 机制可解释性团队负责人 Neel Nanda 说。“能够读懂模型的‘思想’似乎会大有帮助。”

机制可解释性,又称“mech interp”,是一个新兴的研究领域,旨在理解神经网络的实际运作方式。目前,我们大致知道 AI 的运作流程:我们向模型输入大量数据,然后在训练结束时获得一组模型权重。这些权重是决定模型如何做出决策的参数。虽然我们对输入数据与模型权重之间的过程有一定的了解,但这些模式可能极其复杂,且通常难以为人类所理解。

这种情况就像一个老师在批改一份复杂数学题的考试答案。学生(在这里是 AI)给出了正确的答案,但解题步骤看起来像一堆乱涂乱画。这假设 AI 总是能得出正确答案,但实际上并非如此;AI 可能会找到一些无关的模式,并将其视为有效。例如,当前的一些 AI 系统可能会错误地认为 9.11 比 9.8 大。机制可解释性领域的各种方法正开始逐步揭示这些复杂现象,帮助我们理解这些“乱涂乱画”。

“机制可解释性的一个关键目标是试图逆向工程这些系统内部的算法,”Nanda 说。“比如我们给模型一个提示,让它写一首诗,然后它写出了押韵的句子。那么,它是通过什么算法实现的?我们非常希望能搞明白。”

为了在其 AI 模型 Gemma 中发现特征(即表示更大概念的数据类别),DeepMind在每一层中运行了一种名为“稀疏自编码器”(sparse autoencoder)的工具。可以将稀疏自编码器想象成一台显微镜,放大这些层次的细节。例如,当你向 Gemma 输入“chihuahua”(吉娃娃)时,它会触发“狗”的特征,从而点亮模型对“狗”的理解。这种工具被称为“稀疏”的原因在于,它限制了使用的神经元数量,从而推动更高效、更具概括性的数据表示。

使用稀疏自编码器的难点在于如何决定解析的粒度。再次类比显微镜:如果放大过度,可能会让看到的细节难以理解;但如果缩放不足,又可能错过一些有趣的发现。

DeepMind 的解决方案是在不同的粒度上运行稀疏自编码器,调整自编码器要发现的特征数量。该项目的目标并不是让 DeepMind 的研究人员自己彻底分析结果,而是通过开放源码的 Gemma 和自编码器,激发其他研究人员利用这些工具深入研究,从而获得新的洞察。通过在模型的每一层上运行自编码器,研究人员能够以前所未有的方式绘制出从输入到输出的映射过程。

“这对可解释性研究者来说非常令人兴奋,”Anthropic 的研究员 Josh Batson 说。“开放源码的模型意味着更多的可解释性研究可以以这些稀疏自编码器为基础展开。这大大降低了学习和应用这些方法的门槛。”

Neuronpedia,一个专注于机制可解释性的平台,在 7 月与 DeepMind 合作开发了 Gemma Scope 的演示版,目前可以在线体验。在这个演示中,用户可以测试不同的提示,观察模型如何分解提示,并点亮哪些激活特征。你还可以调整模型,比如将“狗”的特征激活值调到很高,然后再问关于美国总统的问题,Gemma 可能会插入一些关于狗的随机胡言乱语,甚至可能直接开始模仿狗叫。

稀疏自编码器的一个有趣之处在于它们是无监督的,也就是说,它们会自己发现特征。这往往会带来一些意想不到的发现,比如模型如何解构人类概念。“我个人最喜欢的特征是‘尴尬特征’,”Neuronpedia 的科学负责人 Joseph Bloom 说。“它似乎出现在对文本和电影的负面批评中。这是一个很棒的例子,展示了模型如何捕捉非常人性化的东西。”

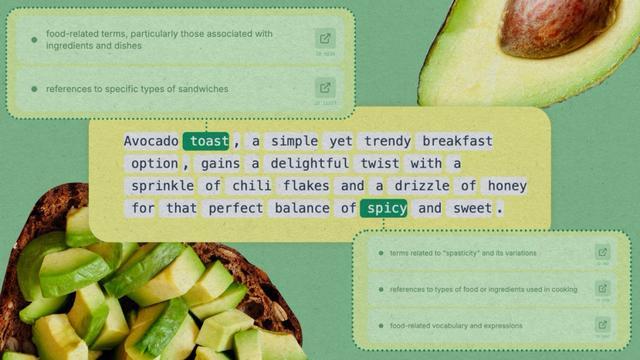

Neuronpedia 允许用户搜索概念,并突出显示在特定词语或符号上激活的特征以及激活强度。“如果你阅读文本,看到绿色高亮的部分,那是模型认为‘尴尬’概念最相关的地方。最活跃的例子通常是某人在向别人说教,”Bloom 补充道。

一些特征比其他特征更容易追踪。“对于一个模型来说,最重要的特征之一是欺骗特征,”Neuronpedia 的创始人 Johnny Lin 说。“但想找到一个特征专门在模型撒谎时被激活并不容易。从我目前所见,还没有成功明确找到这种特征并禁用它的案例。”

DeepMind 的研究与另一家 AI 公司 Anthropic 在今年 5 月的研究有些相似。当时,Anthropic 用稀疏自编码器分析其模型 Claude 讨论旧金山金门大桥时的激活部分。研究人员将与金门大桥相关的激活值放大到极致,以至于 Claude 不再将自己视为 AI 模型,而是自称金门大桥,并以金门大桥的身份回答提示。

虽然听起来有些古怪,但机制可解释性研究可能非常有用。“作为一种工具,它有助于我们理解模型如何进行泛化以及在什么抽象层级工作,这些特征非常重要,”Batson 说。

例如,由 Samuel Marks 领导的一个团队(他现在就职于 Anthropic)使用稀疏自编码器发现了一个特征,表明某个模型将某些职业与特定性别关联起来。研究人员随后关闭了这些性别特征,从而减少了模型中的性别偏见。这项实验是在一个非常小的模型上完成的,因此尚不清楚其成果是否能应用于更大的模型。

机制可解释性研究还可以帮助我们了解 AI 为何会犯错。例如,在 AI 判断 9.11 比 9.8 大的案例中,Transluce 的研究人员发现,这个问题激活了模型中与《圣经》章节和 9 月 11 日相关的部分。他们推测,AI 可能将数字理解为日期,并认为后者时间更晚,从而得出 9.11 大于 9.8 的结论。此外,在许多宗教文本中,9.11 章节通常位于 9.8 章节之后,这也可能导致 AI 认为 9.11 更大。了解了 AI 为何出错后,研究人员降低了模型中与《圣经》和 9 月 11 日相关的激活值,随后模型在被重新提问时得出了正确答案。

此外,这类研究还有其他潜在应用。目前,大型语言模型(LLM)中内置了一种系统级提示,用于应对用户提出诸如“如何制造炸弹”之类的问题。当你向 ChatGPT 提出问题时,OpenAI 会首先秘密地提示模型避免回答制造炸弹或其他不当内容。然而,用户可以通过巧妙的提示绕过这些限制。

如果模型的创建者能够明确 AI 系统中与“制造炸弹”相关的知识节点,他们理论上可以永久关闭这些节点。这样,即使是最复杂的提示,也无法让 AI 提供有关炸弹制造的答案,因为 AI 系统中将彻底缺乏这方面的信息。

然而,目前的机制可解释性研究尚不足以实现这种精确控制。“一个限制在于模型参数调整(steering)的效果还不够好,”Lin 说。“例如,当我们试图减少模型中的暴力内容时,往往会完全抹杀其武术相关的知识。参数调整需要更多精细化的改进。”以“炸弹制造”的知识为例,它并不是 AI 模型中简单的开关,而是可能散布在多个部分中。禁用这些知识可能需要同时牺牲 AI 在化学等领域的部分能力。任何干预可能都有好处,但也会带来显著的代价。

尽管如此,如果我们能够更深入地理解并清晰地观察 AI 的“内心世界”,DeepMind 和其他公司相信,机制可解释性可能为 AI 对齐(alignment)提供一种可行的路径。这一过程的目标是确保 AI 真正按照人类的意图执行任务。

“特别声明:以上作品内容(包括在内的视频、图片或音频)为凤凰网旗下自媒体平台“大风号”用户上传并发布,本平台仅提供信息存储空间服务。

Notice: The content above (including the videos, pictures and audios if any) is uploaded and posted by the user of Dafeng Hao, which is a social media platform and merely provides information storage space services.”