OpenAI创始人的“决裂”:一场关乎AI未来的理念之战

11月20日,微软宣布,OpenAI创始人山姆·阿尔特曼(Sam Altman)和格雷格·布罗克曼(Greg Brockman)将加入微软,领导新的高级AI研究团队。

另一边,OpenAI联合创始人伊利亚·苏茨克维(Ilya Sutskever)宣布,亚马逊旗下视频流媒体网站Twitch的联合创始人埃米特·希尔 (Emmett Shear) 将接任该公司的临时首席执行官。短短一个周末,OpenAI的管理层几经更迭,如今这场惊爆全球的“内斗”似乎尘埃落定了。

据此前报道,苏茨克维是此次巨变的灵魂人物,阿尔特曼被罢免,正是由于其与在苏茨克维在AI安全、技术发展速度以及公司商业化问题上存在分歧。

《每日经济新闻》记者发现,早在今年6月,阿尔特曼和苏茨克维在特拉维夫大学同台对谈时,面临AI风险的提问,两人的回答就有着微妙的不同。苏茨克维承认并强调这些风险,并表示自己对于风险的不确定性。尽管阿尔特曼也同意AI失控的风险且需要不同的社会经济契约来制衡,但他却更倾向描述AI的乐观一面。

外媒分析认为,两人的冲突不能简单理解为“AI加速论者”和“AI末日论者”之间的争论,他们分歧的根源在于如何理解自己正在创造的东西,以及如何达成AGI(通用AI)的方式。而这种冲突在此刻爆发,这很可能是当前的AI水平已经到达一个临界点。

图片来源:视觉中国-VCG111424718601

苏茨克维的世界观为OpenAI“巨震”埋下种子

据彭博社此前报道,OpenAI的联合创始人和首席科学家苏茨克维是此次巨变的灵魂人物,阿尔特曼被罢免,正是由于其与在苏茨克维在AI安全、技术发展速度以及公司商业化问题上存在分歧。

其中,AI安全是最重要的关键词。苏茨克维不止一次提及AI安全的议题,他非常担心AI对社会造成的负面影响,也非常看重“AI对齐”(用人类的反馈来训练模型,让其遵守人类的价值观)的重要性。

这种观念,或许在苏茨克维早期的学术生涯中就已埋下种子。

1985年,苏茨克维出生在俄罗斯西北部的诺夫哥罗德。从5岁到16岁,他一直居住在以色列耶路撒冷。2002年,苏茨克维全家移民至加拿大多伦多。

苏茨克维师从闻名世界的AI科学家杰弗里·辛顿,后者是图灵奖三大巨头之一,被业界称作“AI教父”。2012年,苏茨克维参与发明了辛顿的AlexNet神经网络,这是大模型的重要骨髓,彻底打开了全球深度学习的热潮。

2013年,28岁的苏茨克维与杰弗里·辛顿一同加入谷歌的AI部门,两人被谷歌评价为“不可多得之人”。他也是Google AlphaGo论文的作者之一,用自己的力量团结到早期骨干,一直负责最前沿的开发。

在OpenAI还是非营利组织的阶段,马斯克与苏茨克维较阿尔特曼甚至更为密切。2015年,马斯克与阿尔特曼等人合作,建立了AI实验室,并从谷歌挖来了苏茨克维。马斯克将招来苏茨克维描述为OpenAI成功的关键。

值得注意的时,辛顿发表的“超级AI”将毁灭人类的观点在前几个月曾掀起轩然大波,他之后也因此从谷歌辞职;而马斯克也一直认为AI可能会对人类本身产生威胁,他一直坚持开源AI代码。早在2018年,马斯克就因为对AI安全的担忧和在商业化上的不一致,与OpenAI分道扬镳。

可以说,在苏茨克维的学术和职业生涯中,与其有紧密联系的人都保持着对超级AI的警惕态度,辛顿和马斯克的观念很可能在某种程度上感染了苏茨克维对于AI的认知。

分歧的端倪可追溯至5个月前

11月7日,在OpenAI的首次开发者大会上,阿尔特曼宣布推出的简易定制GPT工具(GPTs),被解读为其欲打造像苹果那样宏伟的商业生态。阿尔特曼被罢免与这一重大发布相隔如此之近,GPTs的发布也被广泛解读为人事巨震的导火索。

对于阿尔特曼对AI的态度,在接受纽约时报采访时,他认为自己在AI辩论中属于中间派。他说,“我相信这将是人类有史以来发明的最重要、最有益的技术。我也相信,如果我们不小心对待它,它可能会带来灾难性的后果,因此我们必须小心驾驭它。”

尽管阿尔特曼一直呼吁监管,从OpenAI自去年11月推出ChatGPT的一系列积极动作来看, 他坚持的是推动商业生态,让GPT的能力快速扩散。

但苏茨克维的立场似乎有些不同,他更看重的是研究如何阻止AGI的失控。今年7月,苏茨克维与OpenAI研究员Jan Leike组建了一支新团队,致力于研究防止AI系统异常的技术解决方案,还表示将投入五分之一的计算资源来解决AGI的威胁。

《每日经济新闻》记者注意到,今年6月,阿尔特曼和苏茨克维在特拉维夫大学同台对谈,当主持人提到AI存在的三个风险:工作岗位受到影响、黑客获得超级智能和系统失控时,两人的回答有着微妙的不同。

图片来源:Youtube

苏茨克维承认这些风险,并表示,“尽管(AI)会创造新的就业机会,但经济的不确定性将持续很长时间。我不确定是否会出现这种情况。这项技术可以用于惊人的应用,可以用来治愈疾病,但也可能创造出比之前任何东西更糟糕的疾病。我们需要适当的结构来控制这项技术的使用。”

尽管阿尔特曼也同意AI失控的风险且需要不同的社会经济契约来制衡,但他更倾向描述AI的乐观一面:“在经济方面,我发现很难预测未来的发展……短期来看,情况看起来不错,我们将看到生产力显著增长;长远来看,我认为这些系统将处理越来越复杂的任务和工作类别。”

AI能力的分界点来临了?

近几个月来,有关AI风险的激烈争论屡见不鲜,图灵三巨头辛顿、Yoshua Bengio和Yann LeCun在社交平台上已展开多轮对决,媒体将这称为“AI加速论者”和“AI毁灭论者”之间的争论。

不过,另一种分析认为,阿尔特曼和苏茨克维的冲突不能简单理解为“AI加速论者”和“AI末日论者”之间的争论。外媒The Algorithmic Bridge称,两人并不像末日论者和加速论者那样对立,相反,他们实际上非常相似——都相信未来AGI给人类带来的好处,这也是他们一同创立OpenAI的基础。

报道认为,分歧根源在于如何理解自己正在创造的东西,以及如何达成AGI的方式。譬如,阿尔特曼认为通过迭代部署产品、筹集资金和建造更强大的计算机可以更好地实现AGI;但苏茨克维认为通过对“AI对齐”等方面进行更深入的研发,并投入更少的资源来制造面向消费者的AI产品,可以更好地实现AGI。

从苏茨克维的角度来看,他想要OpenAI与创立公司初期的使命——创造为人类谋福祉的AGI——保持一致,这无可厚非。

为何这种分歧现在发生,而不是在他们训练 GPT-3 或 GPT-4 时发生呢?并非差异不存在,而是因为AI能力水平的影响不足以采取行动。报道分析称,这很可能是当前的AI水平已经到达一个临界点。

11月16日,在APEC峰会上,阿尔特曼说道,他在OpenAI的工作经历中目睹了知识界限四次被推进,其中最近一次发生在几周前。在今年10月,苏茨维尔在接受《麻省理工科技评论》采访时认为,ChatGPT可能是有意识的。

The Algorithmic Bridge认为,这背后的隐藏含义是——OpenAI董事会认为已接近达成AGI,这是冲突爆发的根源。

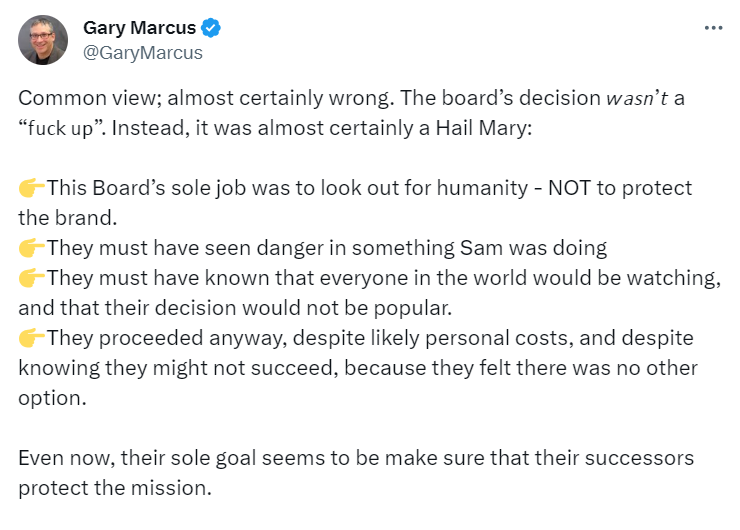

阿尔特曼在近期承认,OpenAI正在开发GPT-5,终极目标是相当于人脑的超级AI。目前关于GPT5并未有最新消息,但外界猜测,GPT5可能会自我修改程序和数据,但“不爱人类”。纽约大学AI教授Gary Marcus就表示,“他们一定看到了山姆所做的事情的危险性。”

图片来源:X平台

纽约时报称,阿尔特曼的离开大概率会助长AI行业的文化战争,也就是,认为应允许AI更快发展的阵营和认为应放慢发展速度以防止潜在灾难性伤害的阵营之间的战争。到底谁是对的?或许只有时间才能证明。

每日经济新闻

“特别声明:以上作品内容(包括在内的视频、图片或音频)为凤凰网旗下自媒体平台“大风号”用户上传并发布,本平台仅提供信息存储空间服务。

Notice: The content above (including the videos, pictures and audios if any) is uploaded and posted by the user of Dafeng Hao, which is a social media platform and merely provides information storage space services.”