云脑黄颂论人工智能所面临的伦理挑战|一刻talks

独家抢先看

2018年10月19日至10月21日,一刻talks在北京77剧场举办“以思想激荡思想,以灵感启发未来”主题的先见未来大会。大会邀请了100位全球杰出领袖围绕智能科技、生物基因、商业创新和未来教育四大领域分享新知。

云脑科技黄颂受邀参加了19日举办的先见大会•智能科技专场。在大会上,黄颂发表以“人工智能所面临的伦理挑战”为主题的演讲。

企业在利用人工智能技术为人类提供便捷的同时,如何保证人们的数据隐私问题是现在人们关注的热点话题。黄颂阐述了现有数据隐私保护技术:数据匿名化、Apple提出的差分化隐私的概念和Google提出的联盟学习的解决方案,并且分析了这三种数据隐私保护技术的优劣势。而云脑科技的数据隐私保护专利BrainSync技术,希望能够抹平现有数据隐私保护技术的弊端,更好地保护用户的数据隐私。2016年发生的特斯拉自动驾驶事故引起大众的广泛关注,事故的责任判定问题更让模型可解释的必要性浮出水面。黄颂以云脑科技在人才招聘领域的模型可解释性实践为例,阐述了云脑科技在为企业人才招聘助力的同时,如何给出判定结果的依据。在演讲的最后,黄颂提及了人工智能对人类威胁最大的问题——安全与和平,黄颂表示:“希望有一天,人工智能赋予机器人的强大力量将会被用于保护人类的和平,而非手足相残。”

以下是演讲全文:

大家好,我是一刻talks的讲者黄颂,一名人工智能的从业者。在过去的十多年间,我利用人工智能技术,在微软亚洲研究院尝试过从全世界的Windows软件质量数据中自动发现代码的缺陷,在爱帮网尝试过为数千万用户精挑细选本地服务商家,在美丽说尝试过帮数亿的女性用户推荐时尚的服饰搭配,在云脑科技尝试过帮助通信和金融的企业用户提高变现效率或监管水平。

今天我想和大家聊聊人工智能所面临的伦理挑战这个话题。

曾经,我天真地以为,作为一名码农,只需要安分地写好代码就可以了——只要我的产品经理不会向我提出一些奇葩的要求,比如说,要求app的主题能根据手机壳的颜色自动调整——我应该不会和人大打出手,也不会和法律、道德、伦理、价值观扯上什么联系。

直到2016年的中秋节,互联网发生了一件轰动一时的事情。某公司给大家发月饼福利,在内网组织了一次秒杀活动。秒杀活动,大家知道,主要是拼速度,刺激且相对公平。但是,有一位懵懂无知的程序员,稍微show了一下智商,写了一段自动抢月饼的脚本。当天下午四点,他如愿抢到了十六个月饼。但是,四点半的时候他被领导约谈,五点半签解约合同,六点被要求离开公司。因为,公司认为,他的行为与公司的价值观不符。你看,写代码的也遇到了价值观的问题。快手的CEO宿华也曾经反思到,“算法的背后是人,算法的价值观就是人的价值观,算法的缺陷是价值观上的缺陷”。

不仅仅是价值观,大数据和人工智能技术经过野蛮生长,已经渗透到我们在座每一个人生活的方方面面,同时也带来了各式各样的伦理道德问题。

我先来说说数据隐私。

我们知道,人工智能本次的繁荣复兴离不开两大技术,深度学习和大数据。深度学习就是一种表达能力灵活多变,并且通过不断尝试优化逐渐逼近目标的机器学习方法。而大数据则是在2000年前后,随着信息交换、信息存储和信息处理三项能力的大幅提升而产生的海量数据。深度学习就好比一台性能强劲的汽车引擎,而大数据则是源源不断输入这台引擎的燃料。

正是大数据的采集,引发了人们对于隐私保护问题的担忧。

据不完全统计,我们国家的摄像头数量已经超过一亿,在全世界居于首位。基本上每个城市80%到90%的数据都是视频数据,一般的城市的数据量都是在几十个PB的规模。每个城市差不多有3万到10万部摄像头,而像深圳、北京这样的大城市则达到了六七十万部。想想看,每天我们只要出门,就会暴露在这么多摄像头的监控之下。结合人脸识别、语义分析、GPS定位等技术,并关联其它一些电子化的数据,比如交通卡、门禁卡、银行卡的刷卡记录,已经可以比较完整地勾画出一个人的行为轨迹,甚至保留了当时的穿着打扮、面部表情这些细节。

再举个例子,现代人的生活已经离不开手机。有数据表明,一般人平均每4分钟就会看一次手机。每天我们在手机上产生大量的数据,其中绝大部分是你不愿和其他人分享的私密信息。比如,用了哪些app,和谁联系过,聊了什么内容,打车去了哪里,拍了哪些照片,搜索过什么关键词,等等等等。相信我,你根本搞不清楚手机上那些令人眼花缭乱的安全隐私设置。净结果就是,你根本不知道谁正在将你的隐私信息转化成为源源不断的商业利润。

欧洲是对个人数据的保护最为关注的地区之一,今年5月25日生效的GDPR法律就是很好的例证。欧美企业正在面临越来越严苛的隐私监管,它对不合规的企业将处以2千万欧元或者全球营收4%的取高的罚款。请注意,是全球营收的4%。

然而,我觉得,仅仅靠法律的威慑是不够的,人工智能的应用的设计者们应该从底层架构上对隐私数据进行足够保护。

我以移动设备为例,简单解释一下。最基本的保护叫做数据匿名化,比如系统会将一个人的姓名转化成为一串不可还原的数字串,这样就无法知道这个人原来的名字是什么。这是最基本的隐私保护。进而,Apple提出了差分隐私的概念,它通过在原始数据中加入噪音来保护真实的数据。当然,噪音加得越多,对数据的保护就越好,但是模型精度的损失就越大。差分隐私让我们可以相对定量地对隐私进行保护。可是,对一般用户来说,虽然加了噪音,但数据离开终端上传到云端,仍然令人不安。因此,Google提出了所谓联盟学习的解决方案——数据并不离开终端设备,直接就地训练,但并不保证满足差分隐私的要求。然而,这种方案并没有完全考虑到手机端设备在数据分布、计算能力、网络资源上极度异质化的特点。我们云脑科技目前正在研发的BrainSync专利技术正是针对这点进行改进,希望在隐私保护和模型精度之间找到更好平衡。

其次,让我们将目光转向人工智能的法律责任这个话题。当人工智能发展得越来越强大,在某些方面已经可以完胜人类的时候,从理智上来讲,将更多的决策任务交给AI是更加合理的选择。然而,不知道你是否想过,当一个决策是AI代替或者辅助人类作出的时候,一但决策失误,这个锅将由谁来背呢?

2016年5月7日,美国佛罗里达州,一名40岁的男子坐在一辆自动驾驶模式的特斯拉轿车上,全速撞上了一辆横穿公路的白色拖挂车,最终车毁人亡。美国国家公路安全管理局最终给出了这起事故的调查结论,特斯拉的自动驾驶模式设计并无明显缺陷,但是同时,驾驶员也没有明显过错。对这起事故各方责任的界定陷入了困境之中,因为传统的法律认为,无过错无责任。在医疗、金融、法律这些领域当中,决策失误很可能带来比较严重的后果,甚至带来生命或财产的损失,所以人工智能的应用必须慎之又慎。

虽然各国的立法者目前在此类事故责任界定问题上并未达成一致,但有一点大家是有共识的,那就是,人工智能系统必须在程序层面具有可追责的特性,能够清楚地解释在每个环节上为什么采用特定的方式运作。模型的可解释性不仅仅可以用于追责,也可以给业务人员更好的直观感受,从而提升他们对AI系统的信任程度和理解水平。

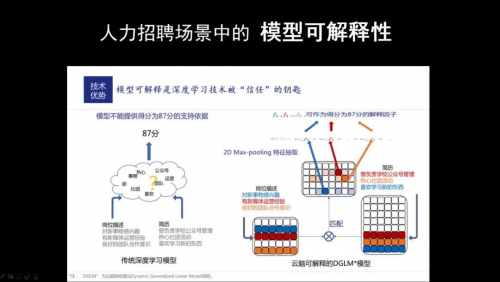

前面我们说过,深度学习是人工智能发展史上的一次重要革命,但是,它自身的可解释性并不好。在实际应用的时候,或者需要对深度模型算法进行较大的改造,或者需要选择其它合适的非深度模型。我们团队很早就意识到可解释性对于人工智能技术在行业落地的重要性,在金融监管、手机通信、人力招聘等行业都有很成功的案例。以人力招聘为例,其最核心的一个算法问题是人岗匹配。传统的深度学习算法并不能给出一个简历和一个岗位匹配度为87分的合理解释。而我们的算法,经过仔细的设计,可以向客户清晰地解释匹配的原因。例如,简历上写的“曾负责学校公众号的管理”可能暗示着候选人“有新媒体运营经验”,而简历上描述的“热心社团活动”可能满足岗位对于“良好的团队合作意识”的这项要求。

最后,我们再来看一个对人类威胁更大的话题,杀人机器人。

在联合国大会上公开展示过的一种杀人机器人,从硬件和软件配置上来看,非常像一个配备有摄像头和传感器的飞行器。它可以做人脸识别,并没有什么稀奇。不过,它同时会携带异型炸药,并且被编程注入了创造者的意志,去完成一个特定的任务,比如消灭一个人类。它不会妥协,不会恐惧,不会背叛,不会中止,并且可以被低成本大量复制。这些特性足以让它成为比一般人类杀手或者士兵更恐怖的杀戮机器。

2018年的7月18号,马斯克、哈萨比斯等2000多人签署宣言:决不允许杀人机器人出现!因为这些人类的顶级人工智能专家们非常清楚,一但潘多拉的盒子被打开,就再也关不上了。

可是,我非常悲观地觉得,这样的宣誓毫无约束力。

日本的科幻小说家贵志祐介写过一本小说《来自新世界》。在小说描绘的未来世界中,相当一部分人类掌握了一种被称作“咒力”的超能力,可以轻易地杀死另一个人,甚至毁灭一座城市。人类因此陷入了恐慌。为了防止咒力被滥用,人类发明了攻击抑制和愧死机制,希望改变基因来控制人类自相残杀的行为。可是百密一疏,基因会有缺陷,咒力也会外泄。在小说中,人类因此付出了惨痛的代价。

大家不妨类比一下,未来的人工智能技术,也许就像小说中的咒力,为大众所掌握,可以用于创造也可以用于毁灭。科幻小说家的担忧,也许并不是空穴来风。如何防患于未然,是全人类绕不过去的一个伦理抉择。

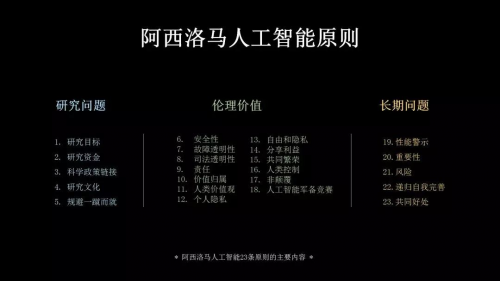

令人略感欣慰的是,国际社会对于人工智能伦理的探索,从未停止过。最著名的研究成果之一,被称为“阿西洛马人工智能二十三条原则”。它是著名的阿西莫夫机器人三大法则的扩展版本,主要分为三大类:科研问题、伦理价值和长期问题。其中就谈及了AI的法律责任以及可解释性、可追溯性的要求,第十二、十三条谈及了对人们隐私的保护,第十八条谈及禁止军备竞赛和杀人武器的制造,这些都是我们刚才讨论过的话题。

“忽如一夜春风来,千树万树梨花开”,人工智能日新月异的发展速度,将许多始料未及的伦理挑战摆在人类的面前。我们没有时间和理由去迟疑。应对这些伦理挑战,不仅仅是少数立法者的职责,更是全体人工智能从业者不可推卸的责任。

作为一名从业者,我意识到,从现在开始,我所写的每一行代码、所设计的每一个算法细节,都会让人工智能的未来更加美好。希望有一天,每个人的隐私数据都能得到充分的尊重和保护,并被合理地用来改善我们的生活;希望有一天,我们的医生、律师和投资者,都能够放心地去采纳智能助手提供的决策建议;希望有一天,人工智能赋予机器人的强大力量将会被用于保护人类的和平,而非手足相残。我因此而自豪。

“特别声明:以上作品内容(包括在内的视频、图片或音频)为凤凰网旗下自媒体平台“大风号”用户上传并发布,本平台仅提供信息存储空间服务。

Notice: The content above (including the videos, pictures and audios if any) is uploaded and posted by the user of Dafeng Hao, which is a social media platform and merely provides information storage space services.”